Автор: Денис Аветисян

Новое исследование предлагает способ проверки стабильности и достоверности ИИ-агентов, используемых в финансовых операциях, выявляя неожиданные различия в поведении моделей.

"Покупай на слухах, продавай на новостях". А потом сиди с акциями никому не известной биотех-компании. Здесь мы про скучный, но рабочий фундаментал.

Бесплатный Телеграм канал![Наблюдается положительная корреляция между детерминированностью модели и соответствием результатов фактическим данным ([latex]r=0.45[/latex], [latex]p<0.01[/latex], [latex]n=51[/latex] конфигурация), что указывает на то, что системы, демонстрирующие последовательность в выдаче результатов, также склонны к большей точности, тем самым опровергая необходимость компромисса между возможностью аудита и качеством работы.](https://arxiv.org/html/2601.15322v1/x2.png)

Представлена методика оценки детерминированности и соответствия требованиям регуляторов для ИИ-агентов, применяемых в финансовых приложениях.

Вопреки ожиданиям о надежности больших языковых моделей, воспроизводимость их решений в критически важных финансовых приложениях остается проблемой. В данной работе, посвященной теме ‘Replayable Financial Agents: A Determinism-Faithfulness Assurance Harness for Tool-Using LLM Agents’, представлена методика (DFAH) оценки детерминированности и достоверности агентов на основе LLM, использующих инструменты. Полученные результаты показывают, что модели меньшего размера способны достигать высокой воспроизводимости, в то время как более крупные модели требуют значительно больших объемов валидационных данных для обеспечения сопоставимой надежности, и что между детерминированностью и соответствием доказательствам существует положительная корреляция. Возможно ли создание универсального стандарта оценки надежности LLM-агентов для финансовых приложений, обеспечивающего соответствие регуляторным требованиям?

Непредсказуемость как Пророчество: Вызовы Надежности в Финансовом ИИ

Традиционные агенты на основе больших языковых моделей, несмотря на свою вычислительную мощь, часто демонстрируют непредсказуемое поведение, что представляет серьезную проблему для применения в финансовой сфере. Эта непредсказуемость проявляется в непостоянстве принимаемых решений и последовательности действий при одинаковых входных данных. В высокорискованных финансовых приложениях, где важна точность и надежность, даже незначительные отклонения могут привести к существенным финансовым потерям и подорвать доверие к системе. Невозможность предсказать реакцию агента на конкретный запрос создает значительные трудности при аудите и контроле, а также препятствует внедрению таких систем в критически важные процессы, требующие безоговорочной стабильности и прозрачности.

Непредсказуемость, свойственная современным языковым моделям, обусловлена непоследовательностью в процессах рассуждения. Даже при идентичных входных данных, алгоритм может генерировать различные последовательности действий и, соответственно, принимать отличающиеся решения. Такое поведение особенно критично в финансовой сфере, где требуется абсолютная надежность и воспроизводимость результатов. Отсутствие стабильности в логике работы подрывает доверие к системе, поскольку невозможно гарантировать, что принятое решение является оптимальным и обоснованным в каждом конкретном случае, что делает использование подобных моделей в критически важных приложениях проблематичным.

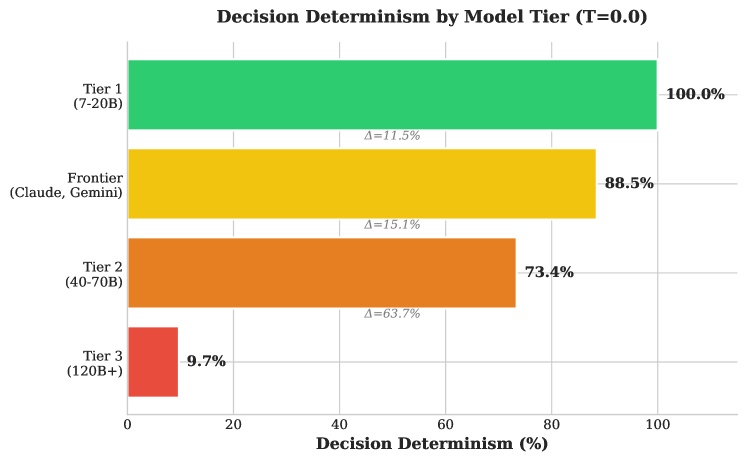

В финансовой сфере, где даже незначительные ошибки могут привести к серьезным последствиям, надежность искусственного интеллекта выходит на первый план. Недостаточно, чтобы агент просто демонстрировал интеллект; необходимо, чтобы его решения были предсказуемыми и воспроизводимыми при одинаковых входных данных. Исследования показывают, что модели первого уровня, с количеством параметров от 7 до 20 миллиардов, способны достичь 100% детерминированности в принятии решений. Эта абсолютная предсказуемость является фундаментом для доверия и возможности аудита, позволяя специалистам финансового сектора понимать и проверять логику, лежащую в основе каждого действия ИИ, что критически важно для соблюдения нормативных требований и предотвращения рисков.

Методология DFAH: Оценка Детерминированности и Правдивости

Фреймворк DFAH представляет собой строгую методологию оценки детерминированности LLM-агентов в финансовых сценариях. Он обеспечивает количественную оценку стабильности и предсказуемости поведения агента при повторных запусках с идентичными входными данными. Методология включает в себя определение степени воспроизводимости финальных результатов и последовательности действий, предпринимаемых агентом для достижения этих результатов. Оценка производится на основе статистического анализа множества итераций, что позволяет выявить и измерить уровень детерминированности агента, критичный для надежного применения в финансовых операциях и анализе.

В рамках оценки детерминированности LLM-агентов в финансовых приложениях, методология DFAH измеряет два ключевых аспекта: детерминированность решений и детерминированность траектории. Детерминированность решений оценивает согласованность конечных результатов работы агента при повторных запусках с идентичными входными данными. Детерминированность траектории, в свою очередь, измеряет согласованность последовательности действий, предпринятых агентом для достижения конечного результата. Низкая согласованность в любом из этих аспектов указывает на непредсказуемость поведения агента и потенциальные риски при использовании в финансовых операциях, требующих надежности и воспроизводимости.

В рамках DFAH фреймворка особое внимание уделяется оценке “обоснованности, обусловленной доказательствами” (evidence-conditioned faithfulness). Это подразумевает проверку того, что решения, принимаемые LLM-агентом в финансовом контексте, базируются на предоставленных данных и подтверждающих доказательствах, а не на галлюцинациях или сгенерированных неправдоподобных аргументах. Оценка проводится путем сопоставления каждого принятого решения с соответствующим фрагментом входных данных, подтверждающим его корректность. Высокий уровень обоснованности, обусловленной доказательствами, критически важен для обеспечения надежности и предсказуемости работы агента, а также для предотвращения финансовых рисков, связанных с принятием неверных решений на основе недостоверной информации.

Архитектурные Подходы к Повышению Надежности

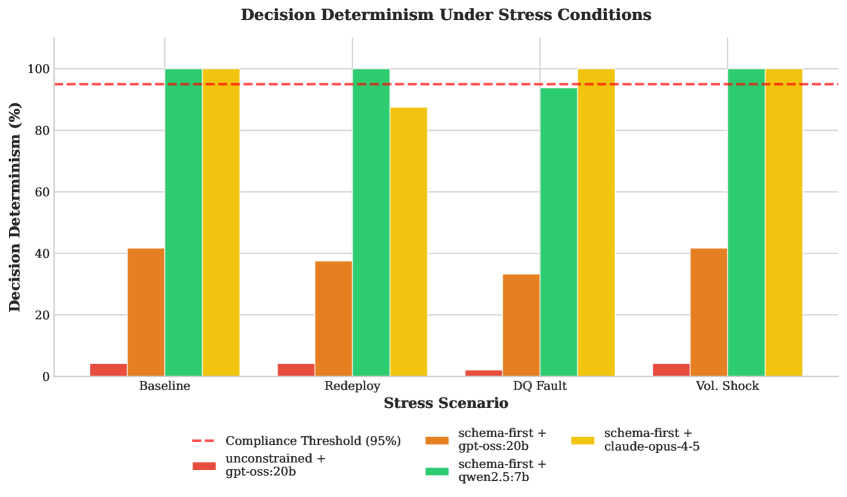

Архитектура, основанная на схемах (Schema-First Architecture), повышает детерминированность агентов искусственного интеллекта за счет ограничения их выходных данных предопределенными схемами. Этот подход существенно снижает вариативность ответов, гарантируя, что результаты будут соответствовать заранее определенному формату и структуре. Ограничение пространства возможных выходных данных упрощает прогнозирование поведения агента и облегчает отладку, а также снижает вероятность генерации нежелательных или непредсказуемых результатов. Использование схем позволяет более эффективно проверять и валидировать выходные данные, что критически важно для приложений, требующих высокой надежности и предсказуемости.

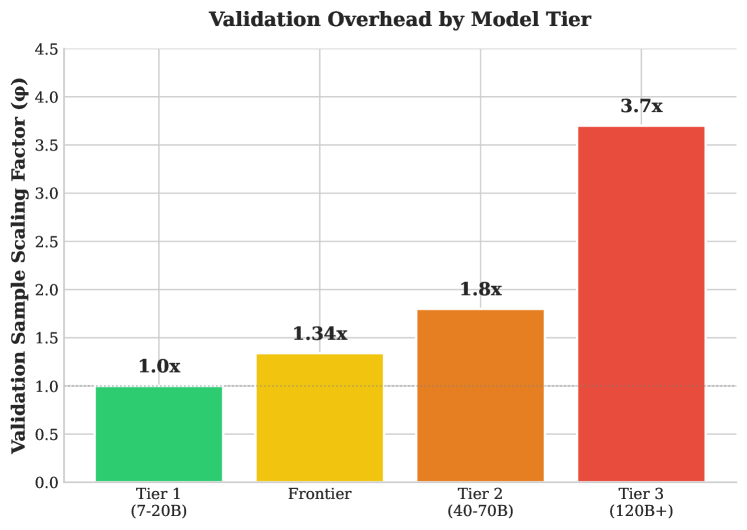

Различные уровни (tiers) языковых моделей (LLM) оказывают существенное влияние на надежность работы агентов. Модели первого уровня (Tier 1) демонстрируют высокую степень согласованности и предсказуемости в ответах, что снижает потребность в обширной валидации. В то же время, модели третьего уровня (Tier 3) характеризуются более высокой степенью непредсказуемости и требуют значительно более тщательной проверки. Для достижения эквивалентного уровня статистической надежности, модели Tier 3 требуют валидационный набор данных, объем которого в 3.7 раза превышает объем, необходимый для моделей Tier 1. Это связано с более высокой дисперсией выходных данных и необходимостью более широкого охвата возможных сценариев для обеспечения стабильной и корректной работы.

Использование стандартизированных финансовых бенчмарков является критически важным для объективного сравнения производительности и надежности различных конфигураций агентов. Эти бенчмарки предоставляют унифицированный набор тестов и метрик, позволяющих оценить точность, стабильность и предсказуемость работы агентов в различных финансовых сценариях. Объективное сравнение, основанное на таких бенчмарках, позволяет выявить наиболее эффективные конфигурации для конкретных задач, снизить риски, связанные с непредсказуемым поведением агентов, и обеспечить воспроизводимость результатов. Без стандартизированных бенчмарков оценка надежности агентов становится субъективной и затрудняет выбор оптимального решения для конкретного применения.

Масштабирование Валидации и Реальные Применения

Разработанный “Фактор масштабирования валидации” представляет собой метрику, позволяющую определить оптимальный размер выборки для проверки эффективности менее мощных моделей, учитывая неизбежный дрейф моделей со временем. Этот фактор не является фиксированной величиной, а динамически изменяется в зависимости от степени ожидаемого дрейфа и критичности задачи, что позволяет избежать как излишней траты ресурсов на валидацию стабильных моделей, так и недооценки рисков, связанных с использованием моделей, чьи характеристики существенно изменились. VSF = k * (1 + \delta), где δ представляет собой ожидаемый процент дрейфа, а k — базовый размер выборки. Внедрение данного подхода позволяет значительно повысить надежность и эффективность процессов валидации, особенно в сценариях, где ресурсы ограничены или требуется высокая скорость адаптации к изменяющимся условиям.

Принципы, разработанные для масштабирования валидации моделей, находят непосредственное применение в критически важных финансовых процессах. Оптимизация портфеля с учетом ограничений, триаж соответствия нормативным требованиям и обработка исключений в DataOps — все эти задачи могут быть значительно улучшены благодаря более надежной и предсказуемой работе больших языковых моделей. Автоматизация таких процессов позволяет не только снизить операционные издержки, но и минимизировать риски, связанные с человеческим фактором и ошибками в данных. Внедрение этих принципов позволяет организациям более эффективно управлять капиталом, обеспечивать соответствие нормативным актам и повышать общую эффективность работы с данными, что особенно важно в условиях постоянно меняющегося финансового ландшафта.

Обеспечение детерминированности и достоверности больших языковых моделей (LLM) является ключевым фактором для их надежного внедрения в практические приложения. Когда LLM-агенты выдают предсказуемые и обоснованные результаты, это значительно снижает риски, связанные с принятием решений на их основе. Приоритет детерминированности позволяет отслеживать и проверять логику работы агента, а высокая достоверность гарантирует, что генерируемые ответы соответствуют фактическим данным и задачам. В результате, организации могут с большей уверенностью автоматизировать процессы, оптимизировать рабочие потоки и добиться существенного повышения эффективности, одновременно минимизируя потенциальные ошибки и финансовые потери.

![Структурированные задачи, такие как генерация SQL-запросов, демонстрируют более высокую детерминированность по сравнению с задачами открытого типа, например, поиском информации (RAG), при [latex]T=0.0[/latex], что подтверждается стандартными отклонениями и соответствует порогу соответствия в 95%.](https://arxiv.org/html/2601.15322v1/x3.png)

Исследование демонстрирует, что предсказуемость агентов, использующих большие языковые модели, зачастую иллюзорна. Маленькие, специализированные модели, как ни парадоксально, проявляют большую устойчивость к вариациям, что подтверждает идею о том, что сложность не всегда ведет к надежности. В контексте финансовой сферы, где точность и воспроизводимость критически важны, этот аспект особенно актуален. Как заметил Джон Маккарти: «Лучший способ предсказать будущее — создать его». Эта фраза отражает суть работы: вместо того чтобы полагаться на непредсказуемость больших моделей, необходимо целенаправленно строить системы, которые демонстрируют желаемое поведение и соответствуют требованиям регуляторов. Создание надежных агентов — это не просто задача программирования, а скорее искусство формирования экосистемы, где каждый элемент работает предсказуемо и слаженно.

Что дальше?

Представленная работа, стремясь обуздать хаос, порождаемый агентами на основе больших языковых моделей, неизбежно сталкивается с фундаментальным вопросом: достаточно ли вообще пытаться контролировать возникающие системы? Попытки гарантировать детерминированность и соответствие истине в финансовых приложениях — это, по сути, попытка заморозить процесс, а мёртвая система — это система, которая никогда не ломается. Разумеется, для регуляторов и финансовых институтов эта «смерть» неприемлема, но следует помнить, что каждое архитектурное решение — это пророчество о будущем сбое.

Наблюдаемый парадокс — более мелкие, специализированные модели демонстрируют большую предсказуемость — указывает на то, что универсальность не является синонимом надёжности. В погоне за всеохватностью теряется контроль, а способность к воспроизведению результатов становится жертвой масштаба. В идеальном решении не остаётся места для людей — для интуиции, для адаптации, для принятия решений в условиях неопределённости. Будущие исследования, вероятно, будут направлены не на создание идеальных агентов, а на разработку инструментов для управления их непредсказуемостью.

Следующим шагом видится не столько повышение детерминированности, сколько создание экосистем, способных абсорбировать ошибки и адаптироваться к изменяющимся условиям. Иными словами, вместо того чтобы строить системы, необходимо их выращивать, позволяя им эволюционировать и самоорганизовываться. А сбой, в этом контексте, — не ошибка, а акт очищения.

Оригинал статьи: https://arxiv.org/pdf/2601.15322.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Стоит ли покупать фунты за йены сейчас или подождать?

- Российский рынок: рубль, микроэлектроника и дивидендные сюрпризы – что ждать инвестору? (23.01.2026 01:32)

- Прогноз нефти

- Золото прогноз

- Квантовый Удар по Крипте и Взлет SEI: Что Ждет Инвесторов?

- Российский рынок акций: Ожидание Давоса, отчетность лидеров и переток в металлы (20.01.2026 10:33)

- ТГК-1 акции прогноз. Цена TGKA

- Серебро прогноз

- Группа Астра акции прогноз. Цена ASTR

- Искусственный интеллект на страже энергосистем: от моделирования до проектирования

2026-01-23 17:05