Автор: Денис Аветисян

В статье представлен эффективный метод оптимизации функций со сложными и недоступными градиентами, основанный на алгоритмах Sequential Monte Carlo.

"Покупай на слухах, продавай на новостях". А потом сиди с акциями никому не известной биотех-компании. Здесь мы про скучный, но рабочий фундаментал.

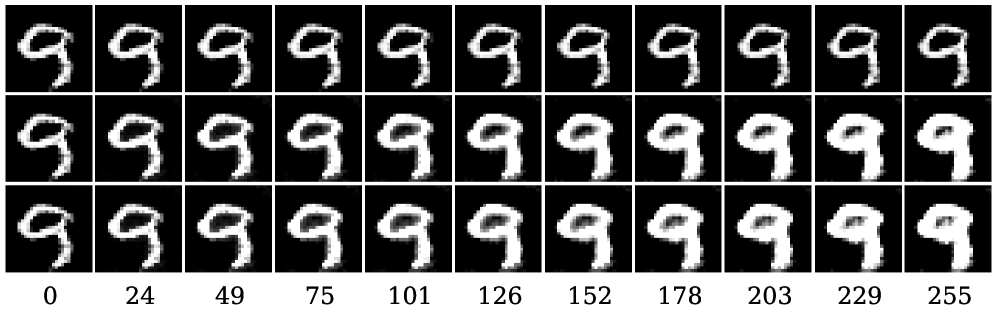

Бесплатный Телеграм канал![Наблюдения за эволюцией плотности [latex]\pi_{\theta_K}[/latex] демонстрируют, что как ImpDiff, так и SOSMC-ULA, при одинаковой начальной инициализации и общем шуме, сходятся к различным распределениям, что указывает на влияние алгоритма на процесс сэмплирования и его способность формировать структуру вероятностного пространства.](https://arxiv.org/html/2601.22003v1/x14.png)

Разработанный фреймворк Sequential Monte Carlo демонстрирует повышенную эффективность в задачах обучения моделей, основанных на энергии, и оптимизации при недоступных градиентах.

Проблема оптимизации функций со недоступными градиентами часто возникает в машинном обучении и статистике, ограничивая возможности эффективной настройки моделей. В работе ‘Efficient Stochastic Optimisation via Sequential Monte Carlo’ предложен новый подход, использующий методы последовательного Монте-Карло (SMC) для оптимизации, заменяя дорогостоящие внутренние циклы семплирования более эффективными аппроксимациями. Разработанный метод обеспечивает значительный прирост вычислительной эффективности и демонстрирует сходимость базовых рекурсий. Можно ли расширить применение данного подхода для решения более сложных задач, связанных с обучением генеративных моделей и настройкой энергетических моделей?

Неуловимые Градиенты: Вызов для Машинного Обучения

Современные модели машинного обучения часто полагаются на оптимизацию функции потерь, L, для достижения высокой точности. Однако, вычисление градиента этой функции, необходимого для алгоритмов оптимизации, таких как градиентный спуск, может быть чрезвычайно затратным с вычислительной точки зрения. Это связано с тем, что функция потерь может быть сложной, включать в себя большое количество параметров и операций, или требовать обработки огромных объемов данных. В результате, прямое вычисление градиента становится непрактичным или даже невозможным, что значительно замедляет процесс обучения модели и ограничивает ее потенциальную производительность. Таким образом, необходимость в эффективных методах оптимизации становится все более актуальной для развития передовых моделей машинного обучения.

Когда вычисление градиента функции потерь становится непосильной задачей, стандартные методы оптимизации, такие как градиентный спуск, сталкиваются с серьезными трудностями. Это происходит из-за того, что алгоритм не может точно определить направление наиболее быстрого снижения ошибки, что приводит к медленной сходимости или даже полной остановке процесса обучения. В результате, модель не способна эффективно извлекать закономерности из данных и демонстрирует неудовлетворительную производительность. Подобные ситуации особенно часто возникают в сложных моделях, например, в глубоких нейронных сетях или при работе с недифференцируемыми функциями, что требует поиска альтернативных подходов к оптимизации, способных обойти проблему недоступных градиентов.

В ситуациях, когда точное вычисление градиента функции потерь становится непосильной задачей, исследователи обращаются к методам его аппроксимации. Такой подход позволяет обойти вычислительные ограничения, используя стохастические методы оптимизации, где градиент оценивается на основе случайной выборки данных, а не на всей обучающей выборке. Это существенно снижает вычислительную сложность, позволяя обучать модели на больших объемах данных и в сложных задачах, где традиционные методы оптимизации оказываются неэффективными или вовсе неприменимыми. Стохастические градиентные методы, такие как стохастический градиентный спуск SGD, представляют собой мощный инструмент, позволяющий находить приближенные решения даже в тех случаях, когда аналитическое вычисление градиента невозможно или требует чрезмерных ресурсов.

Стохастический Хаос: Путь к Приближенному Оптимуму

Методы оценки градиента позволяют обходить необходимость вычисления точных градиентов, используя случайные процессы для получения полезных приближений. Вместо прямого расчета \nabla f(x), эти методы строят оценки на основе случайной выборки данных или использования случайных возмущений. Примерами служат стохастический градиентный спуск (SGD) и методы Монте-Карло. Точность полученной оценки градиента напрямую зависит от размера выборки и дисперсии случайной величины, используемой для аппроксимации. В ситуациях, когда вычисление точного градиента непрактично или невозможно (например, при работе с большими объемами данных или недифференцируемыми функциями), оценка градиента является важным инструментом оптимизации.

Стохастические алгоритмы оптимизации используют полученные оценки градиента для навигации в пространстве параметров, даже когда точная информация о градиенте недоступна. Вместо вычисления точного градиента, эти алгоритмы используют случайную выборку данных или другие методы для аппроксимации градиента, что позволяет им выполнять итеративные обновления параметров в направлении, предположительно ведущем к оптимальному решению. Это особенно полезно в задачах, где вычисление точного градиента вычислительно дорого или невозможно, например, при работе с большими объемами данных или сложными функциями потерь. Алгоритмы, такие как стохастический градиентный спуск (SGD) и его варианты, широко используются в машинном обучении и других областях для решения задач оптимизации.

Качество оценок, получаемых в стохастических методах, напрямую зависит от дисперсии стохастического процесса и эффективности стратегии выборки. Высокая дисперсия приводит к большим отклонениям оценок от истинного градиента, что замедляет сходимость алгоритма оптимизации и требует большего числа итераций для достижения требуемой точности. Эффективная стратегия выборки, напротив, позволяет уменьшить дисперсию оценок при заданном объеме данных, что достигается за счет выбора наиболее информативных подмножеств данных или использования методов снижения дисперсии, таких как контроль дисперсии или важностная выборка. Таким образом, минимизация дисперсии и оптимизация стратегии выборки являются ключевыми факторами для обеспечения стабильности и скорости сходимости стохастических алгоритмов.

![Траектории выборки, полученные с использованием [latex]\pi_{\theta_K}[/latex] для методов ImpDiff и SOSMC-ULA, демонстрируют схожее поведение при одинаковой инициализации и общем шуме.](https://arxiv.org/html/2601.22003v1/x15.png)

Последовательный Монте-Карло: Танец Частиц в Пространстве Вероятностей

Метод последовательного Монте-Карло (Sequential Monte Carlo, SMC) представляет собой подход к аппроксимации вероятностных распределений, основанный на использовании набора взвешенных выборок, формирующих так называемое «распределение частиц» ( \{x_i, w_i\} , где x_i — выборка, а w_i — ее вес). Каждая выборка представляет собой гипотетическое значение переменной, а ее вес отражает вероятность того, что данная выборка соответствует истинному распределению. Аппроксимация распределения строится на основе этих взвешенных частиц, позволяя оценивать вероятности различных событий и отслеживать изменения распределения во времени. Количество частиц определяет точность аппроксимации: большее количество частиц обычно приводит к более точному представлению исходного распределения.

Метод последовательного Монте-Карло (SMC) обеспечивает отслеживание сложных, изменяющихся во времени вероятностных распределений путем последовательного обновления набора взвешенных частиц. Каждый новый поступивший фрагмент информации используется для корректировки весов частиц, отражая их релевантность текущему состоянию системы. Этот процесс позволяет алгоритму адаптироваться к изменениям в распределении вероятностей, избегая необходимости пересчета всего распределения с нуля при каждом новом наблюдении. Эффективность этого подхода особенно заметна в задачах фильтрации и оценки состояния, где необходимо поддерживать актуальное представление о вероятностном распределении в условиях нелинейности и шума. Таким образом, SMC позволяет повысить точность оценки сложных динамических систем по сравнению с традиционными методами.

Эффективность метода Sequential Monte Carlo (SMC) напрямую зависит от размера эффективной выборки (Effective Sample Size, ESS), который количественно оценивает разнообразие распределения частиц. Низкий ESS указывает на то, что большинство частиц вносят незначительный вклад в аппроксимацию, что приводит к ухудшению точности и увеличению дисперсии оценок. Предложенная нами структура обеспечивает более быструю сходимость по сравнению с существующими методами, такими как ImpDiff и SOUL, что подтверждается экспериментальными данными и позволяет получать более точные результаты при меньших вычислительных затратах. ESS = \frac{N}{1 + \frac{1}{W}}, где N — количество частиц, а W — нормализованный вес.

![В представленном примере, взвешенная оценка [latex]\widehat{R}_{particle}[/latex] является значительно более точным приближением к истинному значению [latex]\widehat{R}_{fresh}[/latex] в рамках алгоритма SOSMC-ULA, при этом [latex]\widehat{R}_{fresh}[/latex] быстрее сходится к оптимальной политике [latex]\pi^{*}(H)[/latex].](https://arxiv.org/html/2601.22003v1/x16.png)

За пределами Оценки: Энергетические Модели и Новые Горизонты

Энерго-основанные модели представляют собой принципиально иной подход к определению вероятностных распределений, где вероятность события определяется не напрямую, а через функцию энергии. В отличие от традиционных моделей, где задается плотность вероятности, здесь определяется энергетическая функция E(x), и состояния с низкой энергией считаются более вероятными. Эта гибкость позволяет эффективно моделировать сложные данные, характеризующиеся нелинейными зависимостями и многомерными корреляциями, где прямое определение вероятности затруднительно или невозможно. Такой подход особенно полезен в задачах, где необходимо учитывать сложные взаимодействия между переменными и строить вероятностные модели, адаптирующиеся к различным типам данных и задачам. Благодаря этому, энерго-основанные модели открывают новые возможности для решения широкого спектра задач в машинном обучении и искусственном интеллекте.

Энергетические модели, будучи соединены с методами последовательного Монте-Карло (SMC), демонстрируют значительное повышение эффективности обучения и вывода, особенно в ситуациях, когда традиционные методы сталкиваются с непреодолимыми градиентами или сложными взаимосвязями в данных. Данный подход позволяет обходить проблемы, связанные с вычислением вероятностей в сложных моделях, заменяя их оценкой энергии состояния системы. SMC, в свою очередь, предоставляет мощный инструмент для последовательной аппроксимации распределений вероятностей, позволяя эффективно исследовать пространство параметров даже при наличии сильных зависимостей между переменными. Благодаря этому сочетанию, становится возможным построение и обучение моделей, способных обрабатывать данные с высокой степенью сложности и неопределенности, что открывает новые перспективы в различных областях, включая машинное обучение и статистическое моделирование.

Для эффективного получения выборок из распределений, заданных энергетическими моделями, активно применяются методы динамики Ланжевена. Этот подход, использующий градиент логарифма плотности вероятности — так называемую функцию оценки \nabla_x log p(x) — направляет процесс семплирования, значительно повышая эффективность оптимизации. В отличие от традиционных методов, динамика Ланжевена, управляемая функцией оценки, демонстрирует более быструю стабилизацию траекторий, что позволяет достигать сходимости модели за меньшее количество итераций и улучшает качество получаемых выборок. Такой подход особенно ценен при работе со сложными зависимостями в данных, где прямое вычисление вероятностей затруднено, обеспечивая надежный и эффективный инструмент для обучения и вывода.

![Сгенерированные моделью энергетического основанного моделирования (EBM) образцы (красный цвет) успешно воспроизводят распределение данных (черный цвет) для наборов данных [latex]\mathcal{D}_{2M}[/latex], [latex]\mathcal{D}_{C}[/latex] и [latex]\mathcal{D}_{B}[/latex] (слева направо) после 300 шагов алгоритма Ланжевена, стартующих из случайного шума.](https://arxiv.org/html/2601.22003v1/x12.png)

Укрепляя Основы: Регуляризация и Надежность Моделей

Расхождение Кульбака-Лейблера, или KL-дивергенция, представляет собой меру различия между двумя вероятностными распределениями. Оно позволяет количественно оценить, насколько сильно распределение, предсказанное моделью, отклоняется от заранее заданного априорного распределения, отражающего начальные представления о данных или желаемые свойства модели. По сути, KL-дивергенция измеряет «информационные потери», возникающие при использовании одного распределения для аппроксимации другого. Чем выше значение KL-дивергенции, тем сильнее отличаются распределения и тем больше информации теряется при такой замене. Это делает её ценным инструментом для оценки и контроля поведения моделей машинного обучения, особенно в контексте регуляризации и обеспечения обобщающей способности.

Регуляризация с обратной дивергенцией Кулбака-Лейблера (KL) представляет собой метод, направленный на повышение обобщающей способности моделей машинного обучения. В основе подхода лежит измерение расхождения между распределением вероятностей, предсказываемым моделью, и заданным эталонным распределением. В отличие от стандартной регуляризации KL, которая штрафует отклонение от распределения обучающих данных, обратная KL-регуляризация наказывает отклонение эталонного распределения от предсказаний модели. Это способствует созданию более гладких и устойчивых моделей, менее подверженных переобучению и способных эффективно работать с ограниченными данными. Такой подход позволяет модели сохранять близость к желаемому поведению, что особенно полезно в задачах, где важно избегать резких или непредсказуемых изменений в предсказаниях.

Сочетание дивергенции Кульбака-Лейблера и обратной регуляризации позволяет создавать устойчивые и эффективные системы машинного обучения, способные решать сложные задачи при ограниченном объеме данных и вычислительных ресурсах. Данный подход обеспечивает не только повышение общей производительности, но и улучшение обобщающей способности модели, минимизируя отклонения от желаемого априорного распределения. В процессе настройки наблюдается значительное улучшение ключевых показателей — как вознаграждения, так и значения дивергенции Кульбака-Лейблера, что свидетельствует о достижении оптимального баланса между производительностью и стабильностью модели. KL(P||Q) играет здесь ключевую роль, обеспечивая количественную оценку различий между распределениями и направляя процесс обучения к более надежным решениям.

![Увеличение [latex] \beta_{KL} [/latex] приводит к уменьшению плотности терминального распределения [latex] \pi_{\theta_{K}} [/latex] при фиксированном [latex] R_{lower} [/latex] и общей начальной инициализации и шуме.](https://arxiv.org/html/2601.22003v1/x13.png)

Исследование демонстрирует, что оптимизация сложных систем, особенно тех, где градиенты недоступны, требует нетривиальных подходов. Предложенный фреймворк Sequential Monte Carlo (SMC) выходит за рамки традиционных методов, стремясь взломать ограничения, накладываемые сложностью вычислений. Как однажды заметил Карл Саган: «Мы — звездная пыль, осознающая себя». В данном случае, ‘звездная пыль’ — это алгоритм, стремящийся к самопознанию через последовательное приближение к оптимальному решению, даже в условиях неопределенности и недоступности прямой информации о градиентах. Эффективность SMC в обучении моделей, основанных на энергии, подтверждает, что понимание системы позволяет обойти ее ограничения, а не следовать им.

Куда Дальше?

Представленная работа, хотя и демонстрирует эффективность предложенного подхода к стохастической оптимизации, лишь приоткрывает завесу над истинным масштабом нерешенных задач. Элегантное обходное решение для проблем с недоступными градиентами — это, несомненно, шаг вперед, но система, в конечном счете, всегда сложнее любой модели. Вопрос не в том, чтобы просто найти минимум, а в том, чтобы понять ландшафт, который этот минимум формирует.

Особое внимание следует уделить масштабируемости представленного метода для задач, выходящих за рамки текущих экспериментов. Эффективность Sequential Monte Carlo напрямую зависит от размера ансамбля частиц. Как сохранить точность и вычислительную эффективность при увеличении размерности пространства параметров и сложности целевой функции? Поиск оптимального баланса между точностью и вычислительными затратами — это вечная дилемма, требующая новых, возможно, неортодоксальных решений.

В конечном счете, истинная ценность подобных исследований заключается не в создании очередного оптимизатора, а в углублении понимания самой природы оптимизации. Вместо того, чтобы слепо следовать правилам градиентного спуска, необходимо научиться читать «хаос», видеть скрытые связи и использовать их для «взлома» системы. Возможно, ключ к будущим прорывам лежит не в совершенствовании существующих алгоритмов, а в создании принципиально новых подходов, вдохновленных самоорганизующимися системами и принципами эволюции.

Оригинал статьи: https://arxiv.org/pdf/2601.22003.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Стоит ли покупать фунты за йены сейчас или подождать?

- Европлан акции прогноз. Цена LEAS

- МосБиржа на пути к 2800: Что поддерживает рост и как цифровизация влияет на рынок (26.01.2026 02:32)

- Российский рынок: Инфляция стихает, сырье поддерживает, акции растут (29.01.2026 00:32)

- Российский рынок: Бензин, «Русагро» и ставка: Что ждет инвесторов на следующей неделе (31.01.2026 18:32)

- Крипто-зима и стратегии выживания: что происходит с ликвидностью, MicroStrategy и Binance?

- Серебро прогноз

- Лента акции прогноз. Цена LENT

- ТГК-2 префы прогноз. Цена TGKBP

- АбрауДюрсо акции прогноз. Цена ABRD

2026-02-01 18:14