Автор: Денис Аветисян

Новое исследование предлагает эффективный подход к построению ансамблей моделей для точного прогнозирования и количественной оценки неопределенности в расчетах межмолекулярных взаимодействий.

"Покупай на слухах, продавай на новостях". А потом сиди с акциями никому не известной биотех-компании. Здесь мы про скучный, но рабочий фундаментал.

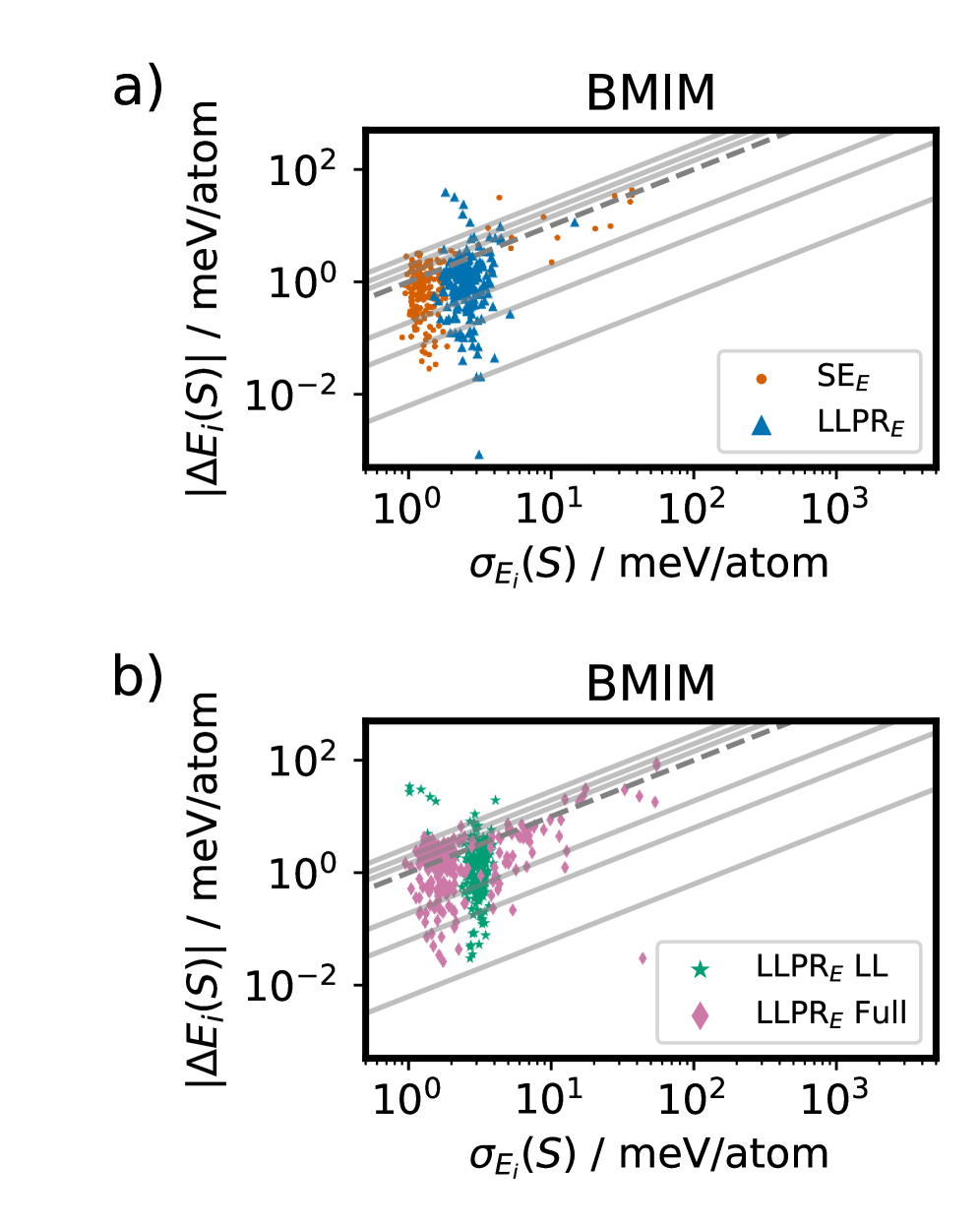

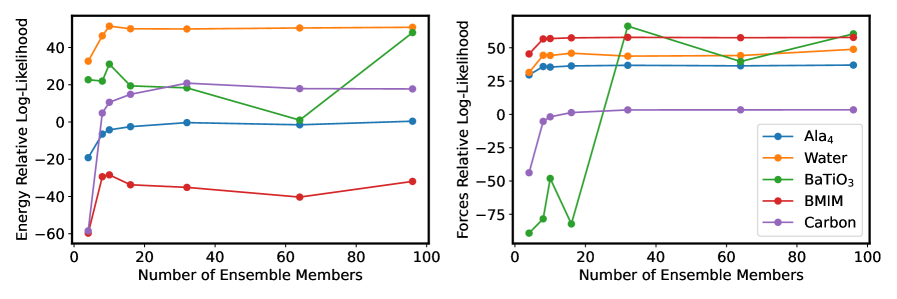

Бесплатный Телеграм канал![Оценка логарифмической правдоподобности показывает, что инициализация и тонкая настройка ансамблей на последнем слое превосходят обучение поверхностных ансамблей с нуля, при этом анализ логарифмической правдоподобности энергии и силы, усредненный по пяти наборам данных и трем случайным начальным значениям, демонстрирует значительное улучшение, особенно для материалов BMIM и [latex]\text{BaTiO}_3[/latex], где выделяются отдельные выбросы, указывающие на чувствительность подхода к конкретным свойствам материалов.](https://arxiv.org/html/2602.15747v1/x4.png)

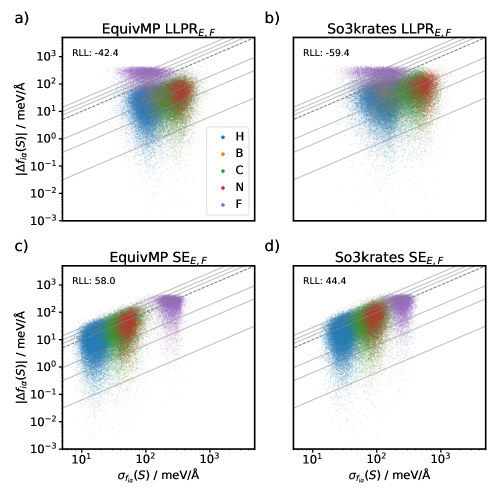

Исследование демонстрирует, что совместное обучение с вероятностной функцией потерь значительно улучшает калибровку моделей по сравнению с постобработочными методами или приближениями на основе последнего слоя.

Несмотря на растущую популярность моделей машинного обучения для разработки межатомных потенциалов, надежная оценка неопределенности предсказаний остается сложной задачей. В работе ‘How to Train a Shallow Ensemble’ систематически исследуются стратегии обучения ансамблей, позволяющие достичь баланса между калибровкой и вычислительными затратами. Показано, что оптимизация отрицательной логарифмической вероятности \mathcal{L} значительно улучшает калибровку по сравнению с ансамблями случайных моделей или приближениями на основе последнего слоя, особенно при моделировании неопределенности сил. Может ли предложенный протокол тонкой настройки ансамблей, обученных с использованием вероятностных функций потерь, стать стандартным подходом к надежной оценке неопределенности в атомном машинном обучении?

Вызов неопределенности в машинном обучении межатомных потенциалов

Методы машинного обучения для создания межatomных потенциалов (MLIPs) открывают новые возможности для ускорения моделирования материалов, однако следует учитывать, что статистические методы обучения, лежащие в их основе, неизбежно вносят элемент неопределенности. В отличие от традиционных подходов, основанных на физических принципах и предлагающих детерминированные результаты, MLIPs опираются на анализ данных, что делает их подверженными статистическим колебаниям и ошибкам. Это означает, что предсказания, полученные с помощью MLIPs, не являются абсолютно точными, а представляют собой вероятностные оценки, зависящие от качества и объема обучающих данных. Понимание и учет этой присущей неопределенности критически важно для надежного применения MLIPs в материаловедении и смежных областях, особенно при решении задач, требующих высокой точности и предсказуемости.

Неопределенность в машинном обучении межатомных потенциалов (MLIP) обусловлена двумя ключевыми факторами. Эпистемическая неопределенность возникает из-за ограниченности знаний о самих параметрах модели — чем меньше данных для обучения, тем выше эта неопределенность. Алеаторическая неопределенность, в свою очередь, связана с присущим шумом в обучающих данных, который невозможно полностью устранить, поскольку отражает физическую сложность системы. Поэтому для надежного использования MLIP в материаловедении необходимо разработать и применять методы, позволяющие количественно оценивать оба типа неопределенности, обеспечивая тем самым достоверность предсказаний и позволяя учитывать возможные погрешности в критически важных расчетах. Игнорирование этих факторов может привести к ошибочным выводам и неверной интерпретации результатов моделирования.

Традиционные межмолекулярные потенциалы, основанные на машинном обучении, зачастую не предоставляют явной оценки неопределенности прогнозов. Это существенное ограничение препятствует надежному использованию моделей в критически важных приложениях, таких как предсказание свойств новых материалов или моделирование поведения систем в экстремальных условиях. Отсутствие количественной оценки погрешности не позволяет адекватно оценить доверие к результатам моделирования, что может приводить к ошибочным выводам и неверным решениям. Вследствие этого, возрастает необходимость в разработке и внедрении методов, обеспечивающих надежную оценку неопределенности в MLIPs, для повышения их практической ценности и расширения области применения.

Байесовские и ансамблевые методы для оценки неопределенности

Байесовские нейронные сети (БНС) предоставляют принципиальный подход к количественной оценке неопределенности, рассматривая параметры модели как вероятностные распределения, а не фиксированные значения. В отличие от стандартных нейронных сетей, БНС позволяют получить не только точечную оценку, но и информацию о распределении вероятностей предсказаний, отражающую уверенность модели. Однако, точное вычисление апостериорного распределения параметров в БНС является вычислительно сложной задачей. На практике для аппроксимации апостериорного распределения часто используются методы, такие как Монте-Карло Дропаут (Monte Carlo Dropout), при котором случайное отключение нейронов во время прямого и обратного проходов служит способом дискретизации апостериорного распределения параметров, позволяя получить несколько предсказаний и оценить их дисперсию как меру неопределенности.

Ансамблевые методы, такие как Deep Ensembles и Shallow Ensembles, представляют собой прямой подход к количественной оценке неопределенности (UQ) путем усреднения предсказаний, полученных от нескольких независимо обученных моделей. В основе данного подхода лежит предположение, что разброс между предсказаниями различных моделей отражает неопределенность модели. Каждая модель в ансамбле обучается на одних и тех же данных, но с разными начальными условиями или с использованием различных подмножеств данных (например, при использовании bootstrap-агрегирования). Итоговое предсказание формируется путем вычисления среднего значения предсказаний всех моделей в ансамбле, что позволяет получить не только точечную оценку, но и оценку дисперсии, характеризующую неопределенность предсказания. Простота реализации и отсутствие необходимости в сложных приближениях делают ансамблевые методы привлекательной альтернативой более сложным подходам, таким как Байесовские нейронные сети.

Метод прямой прогонки мелких ансамблей (Direct Propagation of Shallow Ensembles) повышает эффективность за счет совместного использования общей архитектуры модели (backbone) для всех членов ансамбля, варьируя только параметры последнего слоя. Такой подход существенно снижает вычислительные затраты по сравнению с полным ансамблем, обучая независимые модели. Обучение осуществляется с использованием функции потерь, основанной на отрицательном логарифмическом правдоподобии Гаусса (Gaussian Negative Log Likelihood), что позволяет получить оценки неопределенности, соответствующие распределению Гаусса для предсказаний каждого члена ансамбля. Это позволяет эффективно оценивать и моделировать неопределенность предсказаний, сохраняя при этом вычислительную эффективность.

Эффективная оценка неопределенности с использованием методов последнего слоя

Метод «Last Layer Prediction Rigidity» (LLPR) обеспечивает эффективную оценку неопределенности (Uncertainty Quantification, UQ) посредством аппроксимации апостериорного распределения. В основе метода лежит применение лапласовской аппроксимации к последнему слою обученной нейронной сети. Данный подход позволяет избежать вычислительно затратных процедур, связанных с полным байесовским выводом, фокусируясь на параметрах последнего слоя для моделирования неопределенности предсказаний. Вместо работы со всеми параметрами сети, LLPR оценивает гессиан только для выходного слоя, что существенно снижает вычислительную сложность и позволяет эффективно оценивать неопределенность, сохраняя при этом приемлемую точность.

Метод Last Layer Fine Tuning (LLFT) представляет собой процедуру дополнительной оптимизации финального слоя обученной нейронной сети для повышения точности оценок неопределенности. В отличие от простого применения Лапласовского приближения к последнему слою, LLFT предполагает переобучение только этого слоя с использованием тех же данных, что и при изначальном обучении сети. Этот процесс позволяет адаптировать параметры финального слоя к конкретной задаче, улучшая калибровку вероятностных прогнозов и снижая расхождения между предсказанной и фактической неопределенностью. В результате применения LLFT достигается более точная оценка дисперсии предсказаний, что критически важно для надежных приложений машинного обучения, особенно в областях, где последствия ошибочных прогнозов могут быть серьезными.

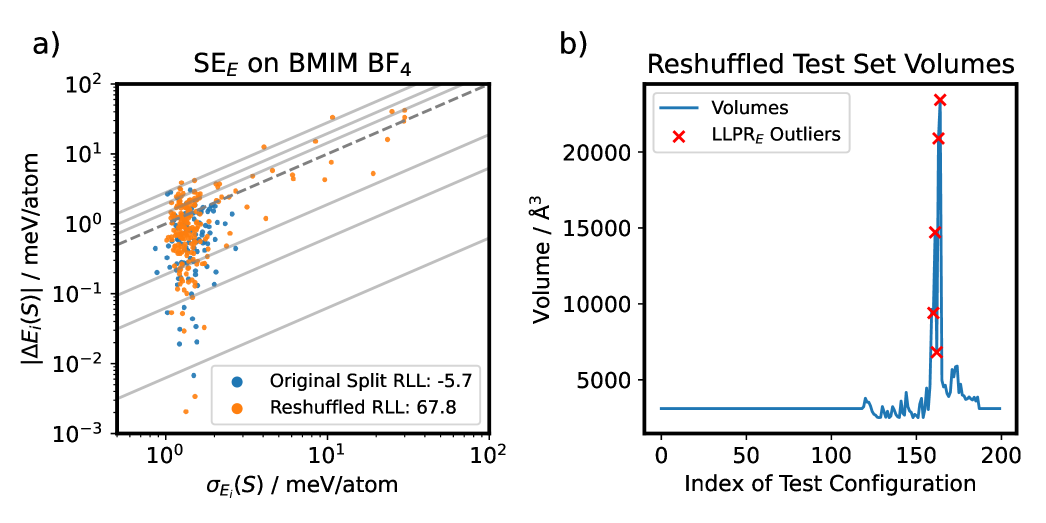

Тестирование и валидация метода LLPR (Last Layer Prediction Rigidity) часто проводится с использованием базовых моделей, таких как MACE_MP0, что подтверждает его практическую применимость. Результаты показывают, что поверхностное ансамблевое обучение с применением вероятностной функции потерь позволяет достичь хорошо откалиброванных оценок неопределенности, с показателем относительной логарифмической вероятности (RLL) до 65.6%. Это указывает на эффективность LLPR в обеспечении надежных и точных оценок уверенности модели в своих предсказаниях.

![Анализ неопределенности силы LLPR BMIM показывает, что использование комбинированной функции потерь NLL при тонкой настройке LLPRE[latex]_ ext{model}[/latex] или применение LLPRE[latex]_ ext{applied}[/latex] к SEE[latex]_ ext{model}[/latex] позволяет эффективно моделировать и уменьшать неопределенность в различных компонентах силы, что подтверждается результатами для LLPR[latex]_ ext{F}[/latex].](https://arxiv.org/html/2602.15747v1/x11.png)

Эквивариантные архитектуры и экосистема IPSuite

Архитектуры, основанные на передаче сообщений с учётом эквивариантности, такие как GMNN, So3krates и EquivMP, играют ключевую роль в создании моделей межмолекулярных потенциалов (MLIP), способных корректно отражать симметрии атомных систем. Эти архитектуры обеспечивают инвариантность выходных данных относительно операций симметрии (вращений, переносов, отражений), что критически важно для физически корректного моделирования материалов. В частности, эквивариантность гарантирует, что предсказанные силы и энергии не зависят от выбора системы координат, обеспечивая надёжность и обобщающую способность MLIP для различных конфигураций атомов. Использование эквивариантных слоёв в архитектуре нейронной сети позволяет эффективно представлять и обрабатывать данные, учитывая геометрические свойства атомных систем, что приводит к повышению точности и эффективности моделирования.

Архитектуры, обеспечивающие ковариантность, такие как GMNN, So3krates и EquivMP, часто интегрируются в программный пакет IPSuite, предоставляя комплексную платформу для обучения и оценки моделей межмолекулярного потенциала (MLIP). IPSuite включает в себя инструменты для подготовки данных, реализации различных архитектур MLIP, оптимизации параметров модели, а также оценки производительности и точности предсказаний, включая вычисление сил и энергии. Пакет поддерживает различные форматы данных и предоставляет интерфейсы для интеграции с другими инструментами моделирования материалов, что облегчает разработку и применение MLIP в различных областях материаловедения и химии. Наличие IPSuite позволяет исследователям стандартизировать процесс обучения и оценки MLIP, обеспечивая воспроизводимость и сопоставимость результатов.

Точное вычисление сил и неопределенности сил является критически важным для надежного моделирования материалов, и ключевую роль в этом играет матрица Якоби. Матрица Якоби, J, описывает производные выходных координат системы по отношению к входным координатам, в данном случае, атомным позициям. Она позволяет вычислить изменение энергии системы при малых изменениях в атомных позициях, что необходимо для расчета сил, действующих на атомы. Более того, элементы матрицы Якоби используются для оценки неопределенности в предсказанных силах, что позволяет оценить надежность модели и выявить потенциальные ошибки. Использование матриц Якоби в алгоритмах автоматического дифференцирования (AD) позволяет эффективно и точно вычислять градиенты и гессианы, необходимые для оптимизации параметров модели и оценки неопределенности.

Будущее MLIPs: Надежные прогнозы и ускоренное открытие

Современные модели межatomных потенциалов на основе машинного обучения (MLIP) способны предсказывать свойства материалов с высокой точностью, однако, критически важным аспектом является оценка надёжности этих предсказаний. Интеграция передовых методов количественной оценки неопределённости (UQ) с архитектурами, учитывающими симметрии кристаллической решетки (equivariant architectures), позволяет MLIP не только выдавать прогноз значения конкретного свойства, но и оценивать вероятность ошибки. Это достигается за счёт учёта различных источников неопределённости, таких как погрешность в данных обучения или неточность самой модели. В результате, исследователи получают не просто числовое значение, но и интервал, в котором с определённой вероятностью находится истинное значение свойства материала. Такой подход значительно повышает доверие к предсказаниям и позволяет более эффективно использовать MLIP для решения сложных задач материаловедения, особенно при решении задач, требующих высокой точности и предсказуемости.

Возможность надежного прогнозирования свойств материалов открывает перед исследователями принципиально новые горизонты, позволяя выйти за рамки простого предсказания отдельных характеристик. Теперь становится возможным изучение сложных материалов и явлений, протекающих в них, с беспрецедентной уверенностью. Это касается не только анализа стабильности и реакционной способности, но и моделирования поведения материалов в экстремальных условиях, таких как высокие температуры или давления. Такой подход позволяет с высокой точностью предсказывать, как материалы будут реагировать на различные воздействия, что критически важно для разработки новых технологий и оптимизации существующих. Благодаря этому, исследователи смогут целенаправленно проектировать материалы с заданными свойствами, значительно ускоряя процесс открытия и внедрения инновационных решений в различных областях науки и техники.

Сочетание передовых методов оценки неопределенности с архитектурами, учитывающими симметрию, открывает новую эру в материаловедении, значительно ускоряя процесс открытия материалов с заданными свойствами. В частности, методика дообучения последнего слоя демонстрирует впечатляющую экономию времени — до 90% по сравнению с обучением с нуля. Исследования показывают, что для моделей GMNN, So3krates и EquivMP, использование ансамбля из 32 членов приводит к ускорению сходимости в 2.7, 6.9 и 17 раз соответственно. Такая эффективность позволяет исследователям значительно сократить время на разработку новых материалов, необходимых для широкого спектра применений — от энергетики и электроники до биомедицины и машиностроения.

Исследование демонстрирует, что надежная оценка неопределенности в машинном обучении потенциалов межатомного взаимодействия требует целостного подхода. Авторы подчеркивают важность совместного обучения ансамбля моделей с использованием вероятностной функции потерь, что значительно улучшает калибровку по сравнению с постобработкой или упрощенными аппроксимациями последнего слоя. Этот принцип созвучен идее о том, что структура определяет поведение системы. Как однажды заметил Нильс Бор: «В конечном счете, не важно, что вы знаете, а важно, что вы делаете с тем, что знаете.». В контексте данной работы это означает, что недостаточно просто построить модель, необходимо тщательно оценить ее надежность и понимать границы ее применимости, чтобы использовать полученные результаты с уверенностью.

Куда двигаться дальше?

Представленная работа, как и любое исследование в области машинного обучения, скорее открывает новые вопросы, чем дает окончательные ответы. Попытка надежно оценить неопределенность в межatomных потенциалах — задача, требующая элегантности в простоте. Очевидно, что интеграция вероятностных потерь непосредственно в процесс обучения дает значительное улучшение калибровки, однако это лишь один элемент сложной системы. Необходимо помнить: нельзя «пересадить сердце», не понимая всего кровотока.

Особое внимание следует уделить масштабируемости предложенных методов. Применимы ли они к системам, значительно более сложным, чем рассматриваемые в данной работе? И как изменится эффективность при переходе к данным, полученным из различных источников или с использованием различных методов симуляции? Структура определяет поведение, и структура данных, безусловно, играет решающую роль.

В конечном счете, настоящим вызовом является создание потенциалов, которые не только точно предсказывают энергию и силы, но и честно сообщают о своей собственной неуверенности. И это не просто техническая задача, но и философская: признание границ наших знаний является признаком зрелости, а не слабости.

Оригинал статьи: https://arxiv.org/pdf/2602.15747.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Стоит ли покупать фунты за йены сейчас или подождать?

- ARM: За деревьями не видно леса?

- SPYD: Путь к миллиону или иллюзия?

- Стена продаж Tron на сумму 10,45 млрд TRX: Великая стена Трондэра

- Наверняка, S&P 500 рухнет на 30% — микс юмора и реалий рынка

- Мета: Разделение и Судьбы

- Геополитические риски и банковская стабильность BRICS: новая модель

- Золото прогноз

- Российский рынок: между геополитикой, ставкой ЦБ и дивидендными историями (11.02.2026 18:32)

- Bitcoin под $70K: Что говорят эксперты о перспективах роста?

2026-02-18 19:25